| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- AI교육

- 생성형ai교육

- 면접 대비

- gpt수업활용

- 공부법

- 알고리즘윤리

- 생성형AI활용

- AI윤리

- 홈스쿨링

- 홈스쿨링 성공 사례

- 챗GPT활용

- 자소서 팁

- ai윤리교육

- 디지털리터러시

- ai수업설계

- 생성형ai수업

- gpt활용수업

- 홈스쿨링 사회성

- 취업 준비

- 입사 지원서

- 자기주도학습

- 자기소개서 작성법

- hr 추천

- 챗gpt활용수업

- 홈스쿨링 준비

- 자소서 작성법

- 미래교육

- 교육혁신

- 자기소개서

- 대학 입시

- Today

- Total

한정하의 조용한 아지트

AI가 만든 정보는 믿을 수 있을까? 허위정보 문제 본문

진짜 같은 가짜, 그걸 만든 건 바로 ‘인공지능’이었다면?

"GPT가 알려준 내용인데 사실이 아니었어요…"

"AI가 써준 보고서를 그대로 냈는데, 출처가 없는 정보들이 있더라구요."

"인터넷에서 본 뉴스가 가짜였는데, AI가 쓴 거라더라구요?"

AI는 지금, 우리가 보는 콘텐츠의 엄청난 양을 만들어내고 있어요.

보고서, 뉴스, 블로그, 심지어 학술 정보까지…

그런데 그 중엔 진짜처럼 보이는 ‘가짜 정보’도 꽤 많다는 사실.

오늘은 AI가 만든 허위정보 문제,

그게 왜 생기고 얼마나 위험한지,

그리고 우리가 어떻게 구별하고 대응해야 하는지 정리해볼게요!

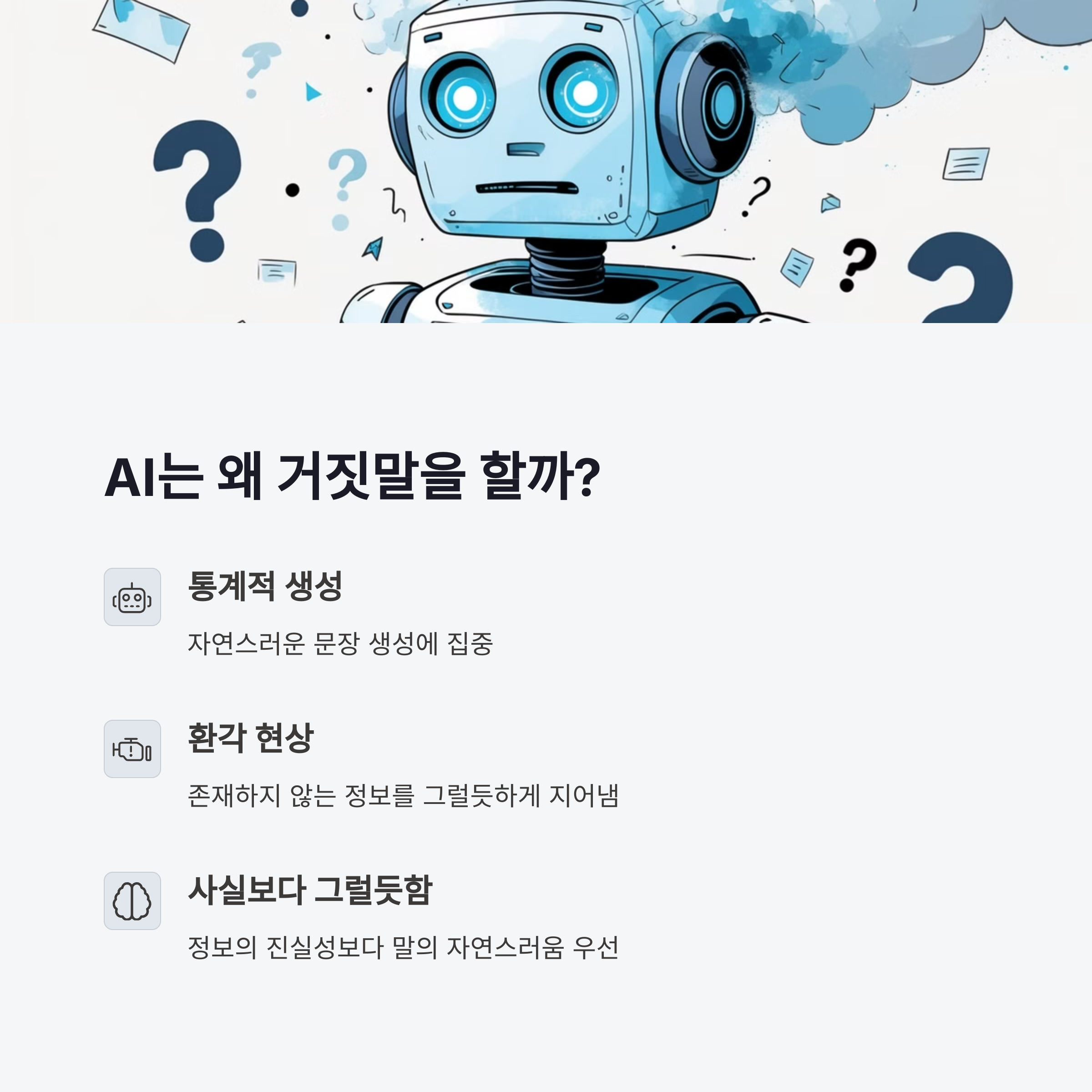

✅ AI는 왜 틀린 정보를 만들어낼까?

생성형 AI(GPT 등)는

✔️ 기존 정보를 통계적으로 분석해서

✔️ 가장 ‘자연스럽고 그럴듯한 문장’을 생성해요.

문제는?

📌 정보의 사실 여부보다, 말이 되는지가 더 중요하다는 점!

그래서 실제론 존재하지 않는 단어, 사건, 인물, 논문 등을

그럴싸하게 ‘지어내는(Hallucination)’ 오류가 종종 발생합니다.

✅ 실제 사례로 보는 AI 허위정보 문제

| 사례 | 설명 |

|---|---|

| 가짜 논문 생성 | 실제 존재하지 않는 학술 논문을 진짜처럼 GPT가 작성 → 대학 보고서에 사용 후 표절 의심 |

| 없는 인물 인터뷰 작성 | 뉴스 스타일 AI에게 맡겼더니, 인터뷰 자체가 허구 |

| 의료 정보 오류 | 병명·증상 관련해서 잘못된 처방 조언 생성 사례 보고 |

| 법률 자문 허위 사례 | 존재하지 않는 판례를 진짜처럼 설명해 소송 관련 혼란 유발 |

| 역사 정보 날조 | 유명 인물의 발언·행적을 잘못 설명한 콘텐츠 유포 |

GPT는 거짓말을 하려는 의도가 없어요.

단지, 그럴듯해 보이는 걸 만들 뿐이죠.

📌 그래서 더 무섭습니다 — 속기 쉽고, 의심하기 어렵거든요.

✅ 문제는 단순 오류가 아니라, 신뢰의 붕괴

✔️ AI가 만든 정보가 뉴스, 학교, 정책 자료 등

공신력 있는 곳에서 쓰이게 되면

→ 사람들은 그걸 진짜라고 믿기 시작하고

→ 잘못된 정보가 ‘팩트’처럼 퍼져버려요.

특히 SNS, 커뮤니티, 포털 뉴스 알고리즘은

📌 "사실 여부보다 클릭 수가 중요한 구조"라

AI가 만든 허위 정보도 엄청나게 확산되기 쉬운 환경입니다.

✅ 그렇다면 AI 정보는 믿으면 안 되는 걸까?

무조건 그렇진 않아요.

AI 정보도 사용자가 어떻게 다루느냐에 따라 충분히 유용해질 수 있어요.

| 조건 | 신뢰도 |

|---|---|

| 출처 명확히 제시된 정보 | 신뢰 가능 |

| AI가 직접 인용한 뉴스·논문 확인 가능 | 비교적 안전 |

| 사용자가 후속 검증한 정보 | 활용 가능 |

| 출처 없이 ‘그럴듯한’ 말만 있는 글 | 신뢰 ↓ |

| 존재하지 않는 출처·논문 제시 | 즉시 의심해야 함 |

✔️ 정리하자면:

👉 AI가 준 정보는 ‘1차 정보’가 아니라, ‘초안’ 혹은 ‘참고자료’로 쓰는 게 가장 좋습니다.

✅ 허위정보 방지를 위한 글로벌 대응은?

- 유럽연합(EU): AI 법안 통해 ‘생성물 라벨링’ 의무화 추진 중

- 구글·MS·OpenAI: 생성 콘텐츠에 ‘AI 생성’ 태그 삽입 시스템 개발

- SNS 플랫폼들: AI 생성 콘텐츠 유통 시 출처 표시, 자동 검열 강화

- 한국: 2024년부터 ‘AI 정보 생성 책임 가이드라인’ 마련 착수 중

하지만 법과 기술보다 먼저 필요한 건

✔️ 우리 스스로의 ‘정보 감별력’이에요.

✅ AI 시대, 우리가 기억해야 할 정보 리터러시

| 실천 방법 | 설명 |

|---|---|

| 출처 확인 습관화 | GPT가 알려준 자료는 반드시 직접 검색해서 확인 |

| 의심 가는 정보는 검색 교차 확인 | 최소 2~3개 이상 사이트에서 비교 |

| 감정 자극 문장은 주의 | 분노, 혐오, 감동 과한 문장은 허위 가능성↑ |

| AI가 썼다는 사실 자체를 인식 | 무비판적 수용은 위험 |

AI가 똑똑해질수록,

우리도 더 똑똑하게 판단해야 하는 시대입니다.

✅ 사실보다 ‘그럴듯한 거짓’이 더 위험할 수 있다

AI는 거짓말쟁이가 아니에요.

하지만 ‘진실을 판별하지 않는 말쟁이’라는 점에서

✔️ 의심 없는 수용은 곧 신뢰의 위기로 이어질 수 있습니다.

정보가 많을수록,

그 안에서 진짜를 가려내는 능력이 진짜 중요한 자산이 되겠죠.

📢 여러분은 AI 정보에 대해 얼마나 신뢰하고 계신가요?

AI가 만든 정보 때문에 당황하거나 오해했던 적이 있다면 댓글로 나눠주세요 😊

'IT·AI 트렌드' 카테고리의 다른 글

| AI는 창의적인가? 인간과 기계의 경계선 (0) | 2025.04.12 |

|---|---|

| AI가 작곡한 음악, 인간의 창작과 구별될까? (0) | 2025.04.11 |

| 챗GPT가 만들어낸 글, 표절일까 창작일까? (0) | 2025.04.11 |

| 생성형 AI가 만든 그림, 저작권은 누구의 것? (0) | 2025.04.10 |

| AI 채용 알고리즘의 불공정성, 사례로 알아보기 (0) | 2025.04.09 |